Was ist Data Science?

von Prof. Jens Flemming

Alle reden über Data Science, Big Data, künstliche Intelligenz, maschinelles Lernen usw. Worüber reden die denn da eigentlich?

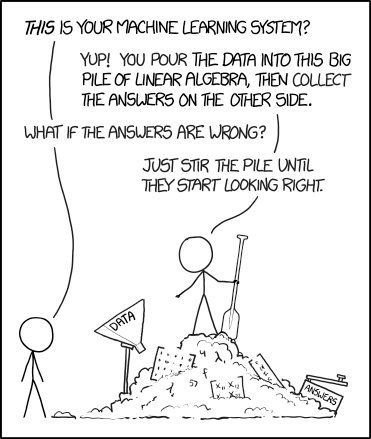

"The pile gets soaked with data and starts to get mushy over time, so it’s technically recurrent." Quelle: Randall Munroe, xkcd.com/1838.

Wissenschaft mit und über Daten

Zum Ende des 20. Jahrhunderts sind die Speicherkapazitäten extrem gewachsen und gleichzeitig die Preise für Speicher-Hardware gefallen. Unternehmen, Regierungen, alle Arten von Organisationen und auch Privatpersonen konnten massenhaft Daten sammeln und speichern ("Big Data"). In einer Welt voller Daten muss irgendjemand darüber nachdenken wie man aus diesen Datenbergen nützliche Informationen gewinnen kann. Informatiker und Mathematiker entwickelten eine Reihe von Methoden zum Extrahieren von Informationen, immer mehr Anwendungen entstanden, die Methoden wurden komplexer,... ein neues Wissenschaftsgebiet war entstanden. Dieses neue Gebiet wuchs rasch und wurde Erwachsen. Es bekam den Name "Data Science" und ist heutzutage als ernst zu nehmendes Forschungs- und Lehrgebiet anerkannt.

Data Science als Wissenschaft deckt alle technischen Aspekte der Datenverarbeitung ab. Die Schnittmenge mit Informatik und Mathematik ist sehr groß, aber auch andere Gebiete spielen in das Data-Science-Gebiet rein, je nachdem wo die zu verarbeitenden Daten herkommen. Die Mathematik liefert fortgeschrittene Methoden zur Datenextraktion. Die Informatik sorgt für deren Realisierung.

Data Science berührt auch rechtliche Themen, ethische Fragen und soziologische Probleme. Darf ich diese Datensammlung für mein Projekt verwenden? Ist es in Ordnung personenbezogene Daten zu sammeln und zu durchsuchen? Welchen Einfluss wird das exzessive Daten Sammeln und Verarbeiten auf die Gesellschaft haben?

Was ein Data Scientist macht

So ziemlich alle Data-Science-Projekte lassen sich in vier Phasen unterteilen.

1. Daten sammeln

Daten müssen irgendwie aufgezeichnet und gespeichert werden. Das Planen und Umsetzen von Prozessen zum Daten Sammeln wird als "Data Engineering" bezeichnet. Typische Aufgaben in dieser Phase sind beispielsweise das Installieren und Konfigurieren von Sensoren, das Aufbauen von Datenbanksystemen, und das Überwachen des Datenflusses mit geeigneten technischen Hilfsmitteln.

2. Daten reinigen und umstrukturieren

Sammlungen von Rohdaten enthalten oft Fehler und Lücken. Rohdaten müssen deshalb zunächst gereinigt werden. Fast immer müssen mehrere Datensammlungen aus unterschiedlichen Quellen zusammengeführt werden um erfolgreich nützliche Informationen extrahieren zu können. Diese Vorverarbeitungsschritte benötigen viel manuelle Arbeit und auch Hintergrundwissen zu den Fachgebieten aus denen die Daten stammen. Eine sorgfältige Datenvorverarbeitung vereinfacht spätere Verarbeitungsschritte und ist mindestens so wichtig wie darauf folgende Modellierungsphase.

3. Ein Modell erstellen

Auf Grundlage der gesammelten und vorverarbeiteten Daten wird ein mathematisches oder algorithmisches Modell erstellt. Je nachdem welches konkrete Problem mit Hilfe der Daten gelöst werden soll, kann solch ein Modell die Daten beschreiben ("descriptive modelling") oder es beantwortet eine Fragestellung anhand der Daten ("predictive Modelling").

4. Die Ergebnisse kommunizieren

Die aus den Daten gewonnenen Erkenntnisse müssen dem Kunde kommuniziert werden. Visualisierungen ist das wichtigste Werkzeug zur Präsentation der Ergebnisse.

Künstliche Intelligenz

Künstliche Intelligenz (KI) ist in gewissem Maße nur ein Buzzword. Es wird immer dann verwendet, wenn ein Computerprogramm etwas tut, dass wir als intelligent betrachten. Beispiele sind Bilderkennung (was ist auf dem Bild zu sehen?), Sprachverarbeitung (Texte übersetzen), autonomes Fahren (Orientieren und Bewegen in einer komplexen Umgebung). Unter der Haube werkelt jedoch stets ein klassisches Computerprogramm, keine Intelligenz.

Viele, wenn nicht sogar alle Methoden der künstlichen Intelligenz basieren auf dem Verarbeiten großer Datenmengen. Bild- und Sprachverarbeitungssysteme werden auf riesigen Sammlungen von Beispielbildern und -texten trainiert. Autonomes Fahren verwendet Reinforcement-Learning, welches man als Sammeln von Daten anhand von Informationen aus zuvor gesammelten Daten interpretieren kann (Datensammeln "on demand"). In diesem Sinne ist künstliche Intelligenz ein Teilgebiet des Data Science.

Es existiert auch eine strenge mathematische Definition des KI-Begriffs: Ein Computersystem ist intelligent, wenn es den Turing-Test besteht. Beim Turing-Test tauscht eine Person gleichzeitig mit einer anderen Person und einem Computer Textnachrichten aus (Chat). Kann die Person nicht entscheiden welcher der beiden Chat-Partner menschlich ist, hat der Computer den Turing-Test bestanden. Bisher hat kein Computersystem den Turing-Test bestanden!

Maschinelles Lernen

Unter maschinellem Lernen (ML) versteht man den Ansatz Computerprogramme zu schreiben, die anhand von Daten lernen das Gewünschte zu tun. Konkreter: Man erstellt ein mathematisches oder algorithmisches Modell mit sehr vielen freien Parametern, welches dann automatisch mittels Optimierungsverfahren an die vorhandenen Daten angepasst wird. Letztlich ist maschinelles Lernen also ein spezielles Vorgehen bei der Software-Entwicklung. Man schreibt ein Programm nicht konkret Zeile für Zeile, sondern erstellt ein sehr allgemeines Programm und lässt die Details automatisch einsetzen anhand der in zuvor gesammelten Daten enthaltenen Informationen.

Das maschinelle Lernen bildet den Kern von Data Science und künstlicher Intelligenz und enthält die mathematischen Komponenten des Gebiets.

Data Science studieren an der WHZ

Im Data-Science-Studiengang an der Westsächsischen Hochschule Zwickau konzentrieren wir uns auf die Datenvorverarbeitung und auf die Modellierung. Data Engineering und die Kommunikationsphase werden überblicksmäßig mit abgedeckt. Visualierungstechniken und -Tools decken wir vollständig ab, da diese nicht nur in der Ergebniskommunikation eine wichtige Rolle spielen, sondern auch bei der Vorverarbeitung und dem Sichten von neuen Daten ("explorative data analysis", EDA) von zentraler Bedeutung sind.

Das recht unscharf abgegrenzte Gebiet der künstlichen Intelligenz spielt eine zentrale Rolle im Studiengang. Neben Methoden des überwachten Lernens (z.B. künstliche neuronale Netze) und des unüberwachten Lernens (Clustering, Anomaly-Detection,...) behandeln wir auch intensiv das zukunftsträchtige Gebiet des Reinforcement-Learning (Lernen durch Versuch und Irrtum).

In this book we also cover this vague field of articifial intelligence, including reinforcement learning.